"AI가 추천했대서 따라 했는데, 왜 그런 결론이 나온 거지?"

"내 대출은 거절됐는데, 왜인지 설명이 없네요."

"AI가 틀릴 수도 있다던데, 어떻게 믿을 수 있죠?"

이처럼 AI의 결정 과정이 ‘블랙박스’처럼 불투명하면

신뢰하기 어렵고, 위험할 수도 있습니다.

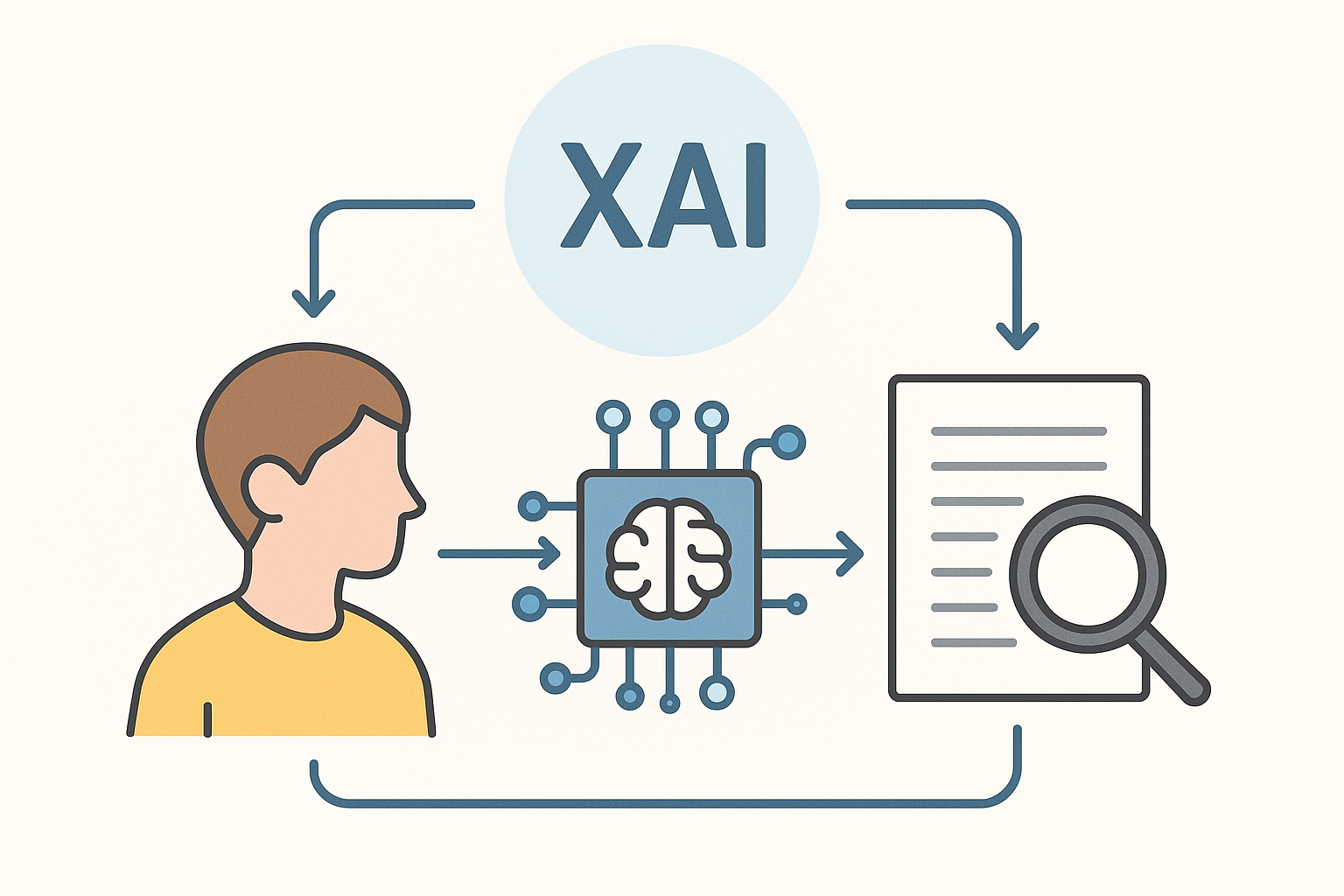

그래서 등장한 개념이 바로 **Explainable AI(XAI)**입니다.

이번 글에서는 XAI가 무엇인지,

왜 중요한지,

그리고 실제로 어디에 쓰이는지

비전공자도 쉽게 이해할 수 있도록 설명드릴게요.

1. XAI란 무엇인가요?

**XAI(Explainable AI)**는

"AI가 내린 판단이나 예측의 이유를 설명할 수 있는 기술"입니다.

예전에는 AI가 ‘결과만 알려주는’ 방식이었다면,

XAI는 **‘왜 그런 결과가 나왔는지 이유까지 보여주는 AI’**라고 생각하면 됩니다.

예시:

- 예측: “이 고객은 이탈할 가능성이 85%입니다.”

- 설명: “최근 3개월 로그인 감소, 결제 중단, 유사 고객 이탈 패턴과 유사”

✅ 즉, XAI는 AI를 이해 가능한 상태로 만들기 위한 기술입니다.

2. 왜 설명 가능한 AI가 필요한가요?

❗ AI의 판단은 종종 신뢰하기 어렵습니다

- "왜 그렇게 추천했는지" 이유를 모르면 사용자는 혼란스럽습니다

- 특히 금융, 의료, 법률 등 고위험 분야에서는 설명이 필수적입니다

❗ 법적/윤리적 책임 문제

- EU AI법(AI Act) 등에서는 설명 가능한 판단 구조를 요구합니다

- 잘못된 판단이 생겼을 때 “누가, 왜, 어떻게 그런 판단을 했는가”를 추적해야 하니까요

📌 AI가 인간의 결정에 영향을 주는 시대,

이제는 단순히 ‘정답’보다 ‘왜 그 정답이 나왔는지’가 더 중요해졌습니다.

3. XAI는 어떻게 작동하나요?

XAI 기술은 크게 두 가지 방식으로 나뉩니다:

✅ 1. 모델 내재적 설명 (Intrinsic)

→ 설명 가능한 모델 자체를 사용하는 방식

- 예: 의사결정나무(Decision Tree), 선형회귀(Linear Regression)

- 장점: 투명함

- 단점: 성능이 복잡한 모델보다 낮을 수 있음

✅ 2. 사후 설명(Post-hoc Explanation)

→ 복잡한 모델(GPT, 딥러닝 등)의 판단을 ‘나중에 해석’하는 방식

- 예: LIME, SHAP, Grad-CAM

- 장점: 성능 높은 모델에도 적용 가능

- 단점: 100% 정확한 해석은 아님 (보조적 수단)

🧠 SHAP(Lundberg & Lee)은 "이 결과에 어떤 요소가 얼마나 영향을 미쳤는지" 숫자로 보여주는 대표적 XAI 기법입니다.

4. 어디에 쓰일까요?

XAI는 특히 다음 분야에서 매우 중요합니다:

| 분야 | 이유 |

| 🏥 의료 | AI 진단 결과가 왜 나왔는지 의사에게 설명 필요 |

| 💳 금융 | 대출 승인/거절 결정의 기준 설명 필요 |

| ⚖️ 법률 | 자동 판결 추천 시스템의 해석 필요 |

| 📈 마케팅 | 어떤 요소가 구매율을 높이는지 분석 |

| 🤖 AI 모델 디버깅 | 모델의 편향이나 오작동 원인 분석 |

✅ 설명 가능한 AI는 ‘기계의 말’이 아닌

사람이 이해하고 수용할 수 있는 언어로 결과를 전달하는 기술입니다.

5. 한눈에 보는 XAI의 장점

| 장점 | 설명 |

| ✅ 신뢰성 향상 | 사용자에게 AI를 믿을 수 있는 이유 제공 |

| ✅ 책임성 확보 | 오류 발생 시 원인 추적 가능 |

| ✅ 규제 대응 | 법률적으로 설명 요구에 대응 가능 |

| ✅ 모델 개선 | 어떤 요소가 문제였는지 파악해 모델 개선 가능 |

6. AI vs XAI – 왜 둘 다 중요할까?

- AI가 아무리 정확해도, 이유를 설명하지 못하면 의심받습니다

- 설명만 많고 정확하지 않으면, 결과를 쓸 수 없습니다

💡 그래서 미래의 AI는 단순히 ‘정확한 AI’가 아니라,

‘이해 가능한 AI’로 발전해야 합니다.

💬 마무리하며

AI가 우리 삶을 바꾸고 있는 지금,

XAI는 그 변화를 책임지고 설명해주는 도우미입니다.

기계의 똑똑함만 믿는 시대는 지나갔습니다.

이제는 왜 그런 결정을 했는지, 내가 납득할 수 있어야

진짜로 AI와 함께 살아갈 수 있겠죠?

📌 앞으로 AI를 볼 땐 꼭 물어보세요.

“그 판단, 왜 그렇게 한 거야?”

XAI는 그 질문에 대답해 줄 수 있는 기술입니다.

✍️ 질문 드려요

여러분은 AI가 어떤 결정을 내렸을 때

"왜 그렇게 판단했지?"라는 궁금증을 가져본 적 있나요?

AI가 설명해주는 기능이 있다면 어디에 가장 필요할까요?

댓글로 의견을 나눠 주세요

'기술 개념' 카테고리의 다른 글

| AI 이미지 생성 원리 – DALL·E, Midjourney, Stable Diffusion 쉽게 이해하기 (8) | 2025.04.30 |

|---|---|

| Transformer 모델이란 무엇인가? – AI를 똑똑하게 만든 핵심 기술! (0) | 2025.04.29 |

| LLM(대형 언어 모델)의 동작 원리, 쉽게 설명해드립니다! (2) | 2025.04.29 |

| ChatGPT (챗GPT) 심층 리서치 메뉴– AI가 자료조사까지 대신해주는 시대, 직접 써보셨나요? (6) | 2025.04.25 |

| Multimodal AI란? – 텍스트 + 이미지 + 음성까지 이해하는 AI의 시대 (0) | 2025.04.25 |